So entsteht (d)eine Filterblase

Was Algorithmen mit unserer Rubrik Demokratie zu tun haben? Wir erhalten unsere Informationen übers Internet, dortige Veränderungen der Inhalte erzeugen also auch entsprechende Veränderungen in unserer Denkweise. Empfehlungsalgorithmen sind im Grunde dafür da, unser Verhalten digital zu bewerten und dementsprechend Suchergebnisse nach unseren Vorlieben zu filtern. Jeder hat sich schon mal gewundert, warum nach dem Surfen im Web ein im Shop betrachteter Artikel als Werbeanzeige auf der nächsten Seite wartet. Auf den ersten Blick gar nicht so unpraktisch könnte man denken, unser Selbstexperiment beweist aber das Gegenteil.Was Algorithmen mit unserer Rubrik Demokratie zu tun haben? Wir erhalten unsere Informationen übers Internet, dortige Veränderungen der Inhalte erzeugen also auch entsprechende Veränderungen in unserer Denkweise. Empfehlungsalgorithmen sind im Grunde dafür da, unser Verhalten digital zu bewerten und dementsprechend Suchergebnisse nach unseren Vorlieben zu filtern. Jeder hat sich schon mal gewundert, warum nach dem Surfen im Web ein im Shop betrachteter Artikel als Werbeanzeige auf der nächsten Seite wartet. Auf den ersten Blick gar nicht so unpraktisch könnte man denken, unser Selbstexperiment beweist aber das Gegenteil.

Selbstexperiment

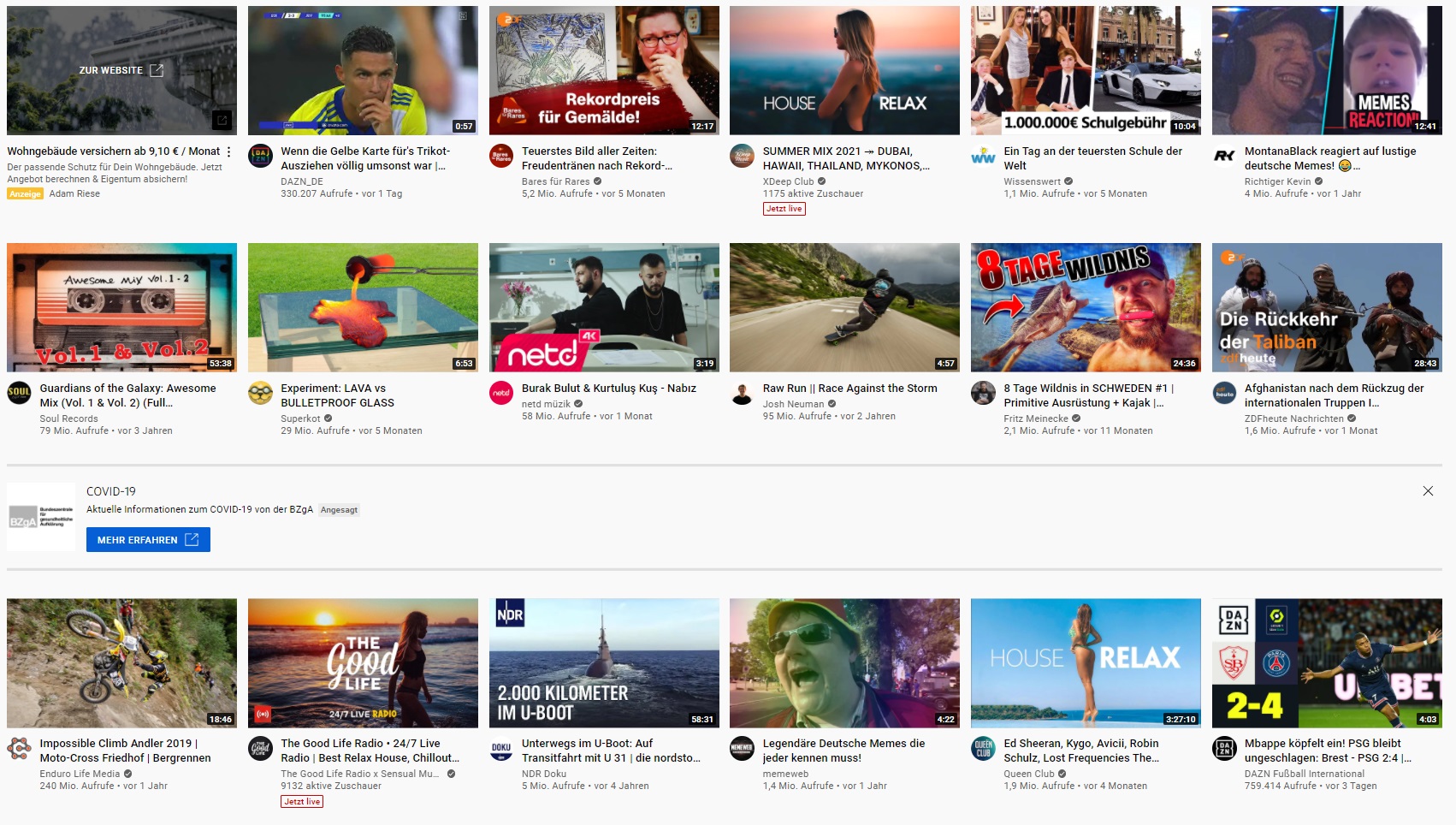

Wir haben mal gecheckt, wie der Algorithmus unsere YouTube Startseite verändert. Dafür haben wir uns mit zwei unbenutzten Profilen das Thema Klimawandel herausgegriffen und die zwei Gegenpole Klimaleugnung und Klimakatastrophe eingenommen.Das klare Ergebnis nach weniger als zehn gesehenen Videos: Es bestehen schon deutliche Unterschiede auf den beiden Profilen. Gerade auf der Seite der Klimaleugner erkennt man, dass die Informationen immer unpopulärer werden. Statt mehreren Millionen erscheinen sogar Videos mit weniger als 10 Tausend Aufrufen. Der Anteil der Videos zur „eigenen Meinung“ steigt, auf der Seite der Klimakatastrophe erreicht er sogar fast die Hälfte. Neben der klaren Bevorzugung einer Meinung ist ein weiteres Phänomen, dass immer mehr Videos erscheinen, die einen negativen Eindruck zu einem bestimmten Thema vermitteln.

Fazit: Wenn man brav, wie in der Schule, das Fazit zieht, erkennt man schnell die Falle der sogenannten Filterblase. Diese wird so benannt, weil einem Videos mit ähnlichem Inhalt zu vorher gesehenen Videos empfohlen werden. Das hat eine einseitige Ansicht zur Folge und da immer mehr ähnliche „Katastrophenvideos” empfohlen werden, rutscht man immer weiter in eine einseitige Darstellung ab, die nicht selten in der Welt der Verschwörungstheoretiker endet.

Wenn man also nicht mit Aluhut auf dem Kopf, um sich vor den Telepathiewellen der Regierung zu schützen, enden will, gibt es Rettungsmöglichkeiten. Viele glauben, das reine Zurücksetzen des Such- und Wiedergabeverlaufs auf Plattformen reicht, da somit bisherige Daten gelöscht werden, doch der Suchfilter bleibt weiter aktiviert. Stattdessen muss man dies in den Kontoeinstellungen seines Profils (hier Google Konto) ändern. Am besten wäre es bei der Erstellung seines Kontos direkt darauf zu achten, anstatt überall den Haken zu setzen. Sich selbst zu schützen, bedarf halt auch etwas Aufwand.

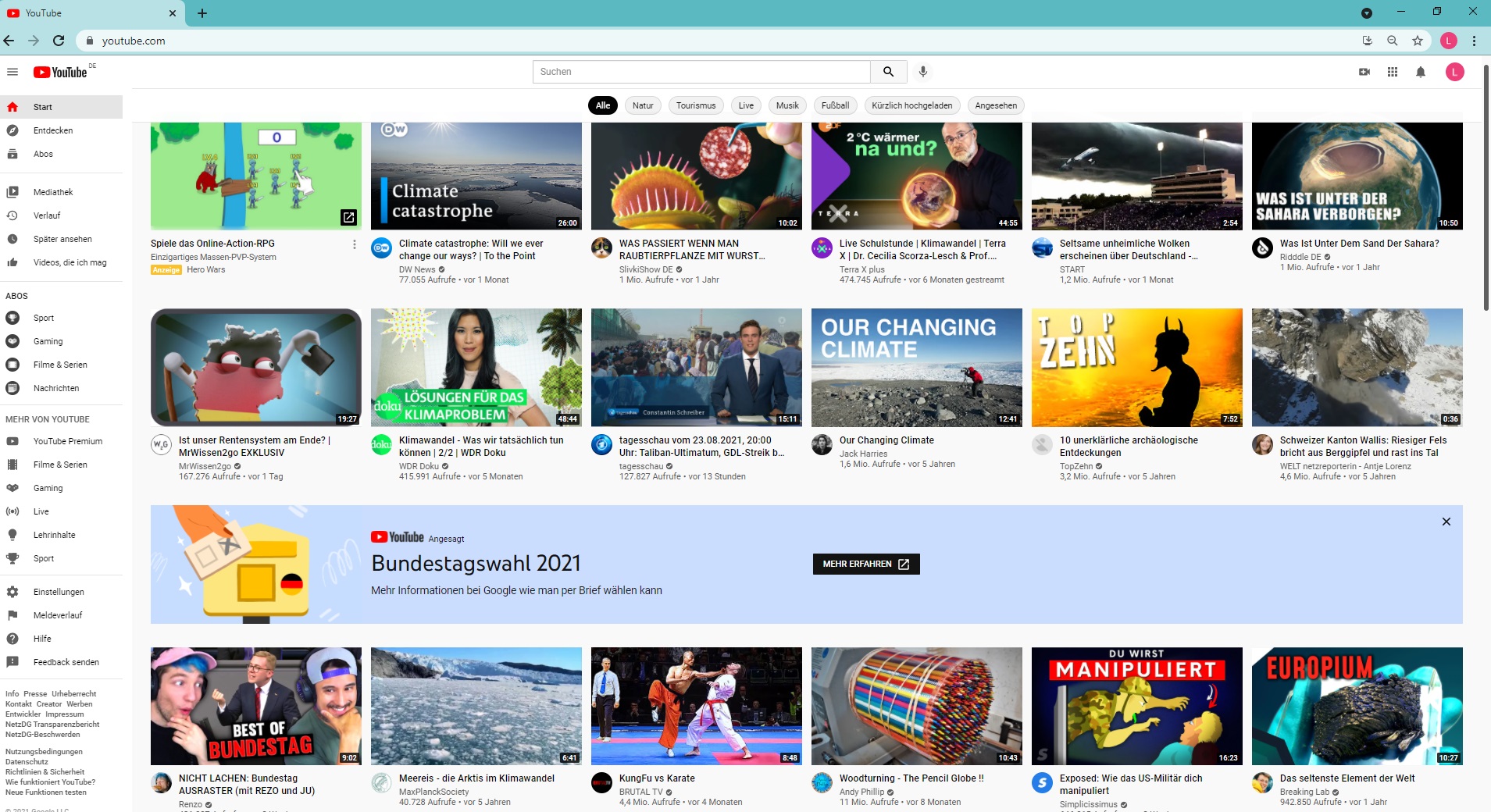

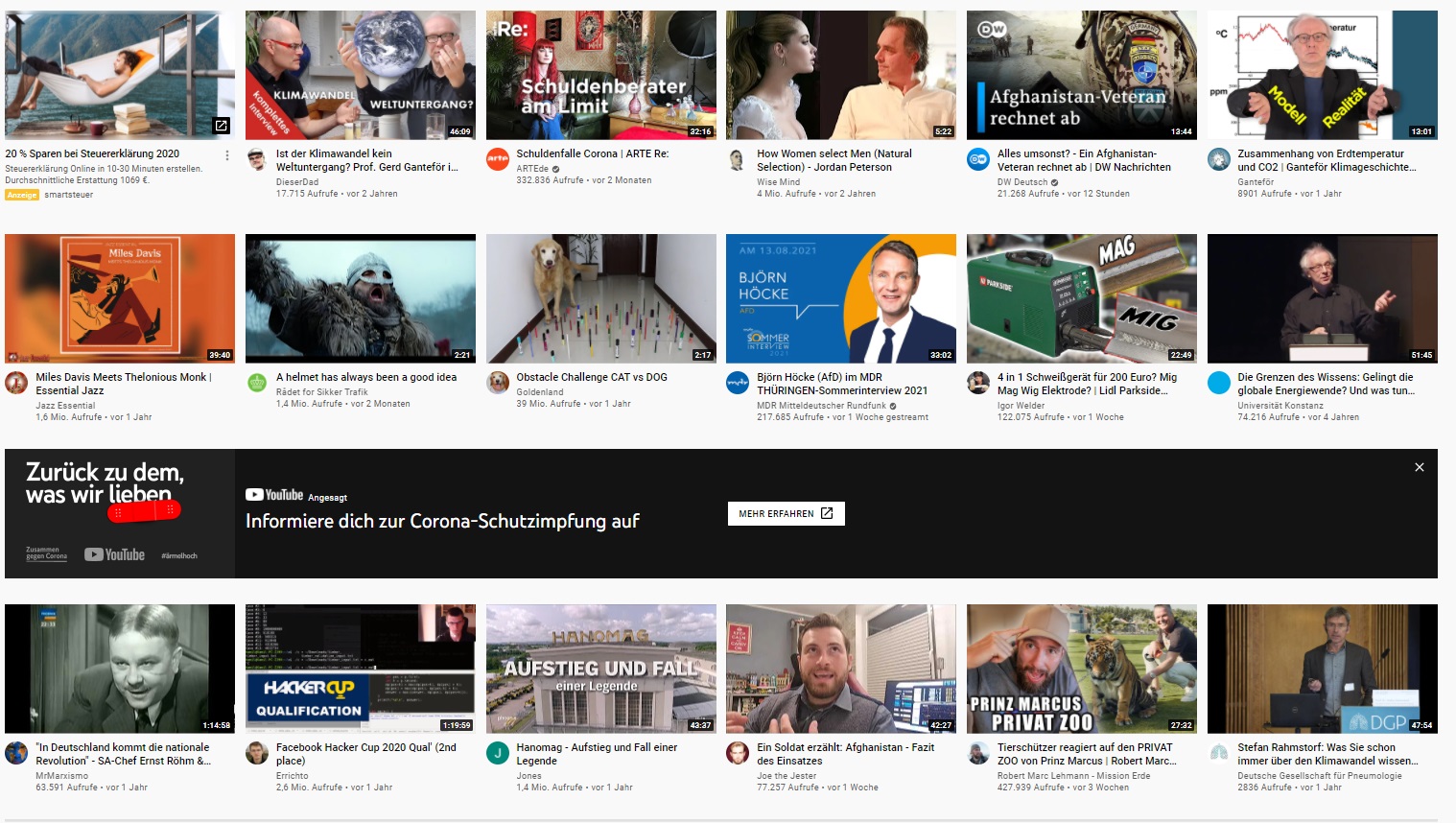

So sah unsere YouTube-Startseite zum Beginn des Experiments aus:

Schaut man bewusst Klimaleugner-Videos, wandeln sich die Video-Vorschläge auf der Startseite schnell in diese Richtung:

Tendiert man in Richtung Klimakatastrophe, gelangt man ebenso schnell in eine Filterblase: